Azure durchläuft gerade eine Phase der Umgestaltung: Dienste wie Azure SQL Edge werden für 2025 abgekündigt. Und auch das Backup Center wird mittelfristig ersetzt werden. Der Fokus neuer Funktionen geht in Richtung KI und der sicheren Verwaltung komplexer Infrastrukturen. Wir stellen Ihnen die drei aktuell wichtigsten Änderungen in Microsoft Azure vor:

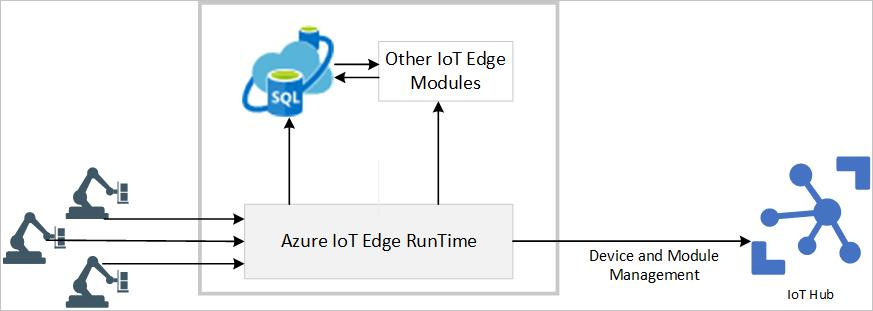

Azure SQL Edge geht

Azure SQL Edge wird am 30. September 2025 eingestellt. Damit der Übergang zu einer Alternative reibungslos klappt, sollten Unternehmen jetzt beginnen, zu einem der folgenden drei Dienste zu migrieren.

- SQL Server Express Edition: SQL Server Express Edition ist kostenlos und verwendet dieselbe Datenbank-Engine wie Azure SQL Edge. Dadurch kann sie genau wie SQL Edge in Containern ausgeführt werden. Sie eignet sich besonders für Datenbank-Workloads, die auf einem Socket/4 Kernen, 1.410 MB RAM und maximal 10 GB pro Datenbank ausgeführt werden können.

- SQL Server Standard Edition: Für alle Anwendungen, die die Grenzen der Express Edition überschreiten, ist die SQL Server Standard Edition eine kostengünstige Alternative. Sie eignet sich besonders für kleine und mittlere Unternehmen und unterstützt grundlegende Anforderungen an Datenmanagement und Business Intelligence. SQL Server Standard bietet robuste Leistung, Sicherheit und Skalierbarkeit für Organisationen, die keine erweiterten Unternehmensfunktionen benötigen.

- SQL Managed Instance mit Azure Arc: Diese robuste Lösung bietet fast hundertprozentige Kompatibilität mit dem neuesten SQL Server-Datenbankmodul. Azure SQL Edge-Kunden können damit nahtlos und mit minimalen Änderungen zu einem verwalteten Datenservice wechseln, ohne ihre Datenhoheit zu verlieren. SQL Managed Instance verfügt außerdem über integrierte Verwaltungsfunktionen, die den administrativen Aufwand erheblich reduzieren. Diese Lösung eignet sich daher für Unternehmen, die ihre Dateninfrastruktur modernisieren möchten.

Planen Sie jetzt schon den Umstieg auf einen Service, der zu Ihrem Unternehmen passt. Lassen Sie sich dabei am besten von Ihrem IT-Partner beraten. Unsere Skaylink-Expert*innen helfen Ihnen gern weiter!

Verbessertes Backup Center: Azure Business Continuity Center (ABCC)

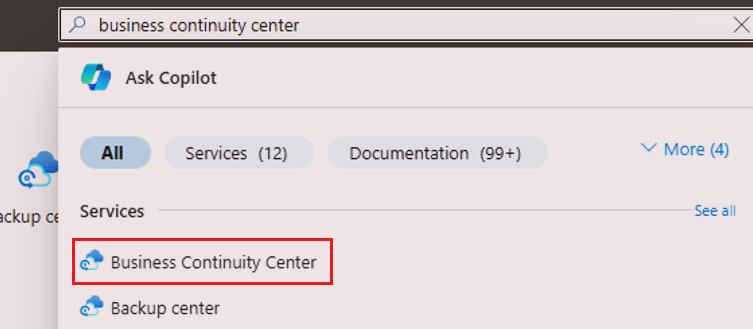

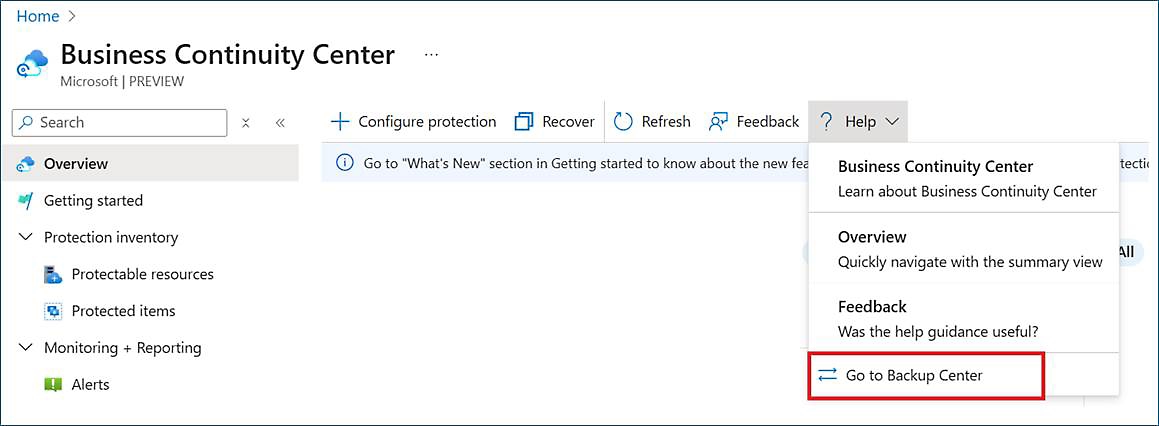

Mehr Datenschutz in komplexen hybriden Arbeitsumgebungen – dafür hat Microsoft das Azure Business Continuity Center (ABCC) entwickelt. Es ist ein erweitertes, zentralisiertes Backup Center, das Sicherungen und Notfallwiederherstellungen in Azure- und Hybrid-Umgebungen und über Lösungen wie Azure Backup und Azure Site Recovery einfacher macht. ABCC ist jetzt allgemein verfügbar und wird das Backup Center mittelfristig ersetzen.

Der Einstieg ins ABCC ist einfach und kostenlos. Wer aktuell das Backup Center verwendet, braucht nichts tun, außer im Azure-Portal nach Azure Business Continuity Center zu suchen. Um den Übergang zum ABCC zu erleichtern, wurde das Backup Center aus der globalen Suche im Azure-Portal entfernt. Es gibt aber immer noch die Option, vom ABCC zum Backup Center zu wechseln.

Vorschau auf erweiterte GenAI-Gateway-Funktionen für große LLMs

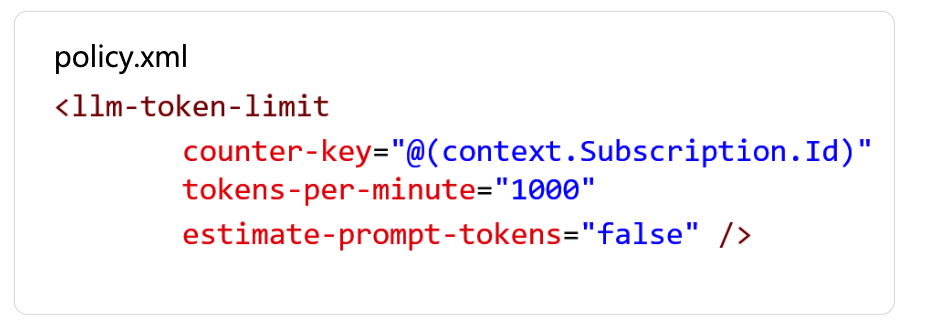

Microsoft hat die GenAI-Gateway-Funktionen für Anwendungsfälle mit Large-Language-Modellen (LLMs) überarbeitet. Sie sind jetzt in der Vorschau verfügbar. Mit Hilfe der neuen Richtlinien kann nun eine breitere Palette von LLMs, die in Azure AI Studio verfügbar sind, über die Azure AI Model Inference API unterstützt werden. Die drei wichtigsten Highlights:

- LLM Token Limit: Hierüber lassen sich Token-Limits für Interaktionen mit großen Sprachmodellen definieren und erzwingen. Die Richtlinie blockiert automatisch Anforderungen, die das festgelegte Limit überschreiten. Dadurch haben Administrator*innen mehr Kontrolle über die Kosten und die Ressourcennutzung.

- Token-Metriken: Über die Richtlinie erhalten Administrator*innen in Echtzeit Metriken und Details zum Verbrauch von Token. So lassen sich Muster in der Verwendung von Token erkennen, was das Kostenmanagement erleichtert. Kosten lassen sich damit nämlich eindeutig Teams, Abteilungen oder Anwendungen zuordnen.

- LLM Semantic Caching Policy: Diese Richtlinie speichert Antworten basierend auf dem semantischen Inhalt von Eingabeaufforderungen zwischen. So lassen sich redundante Modellinferenzen reduzieren, die Latenz verringert sich. Das Ergebnis sind eine optimierte Auslastung der Ressourcen und schnellere Antwortzeiten für häufig auftauchende Abfragen.

Die verbesserten Funktionen sollen die Nutzung von LLMs in Zukunft effizienter und kostengünstiger machen.

Moderne Infrastruktur ist hoch flexibel. Allerdings muss sie dafür auf einem aktuellen Stand gehalten werden. Prüfen Sie deshalb regelmäßig, ob Ihre Infrastruktur noch allen notwendigen Anforderungen entspricht. Unsere Expert*innen für Cloud-Infrastruktur unterstützen Sie gern dabei – melden Sie sich einfach bei uns!